Пример дешевого использования современных технологий.

1. Берем дешевое оборудование от HikVision под любым суббрендом - стоимость 2 камер с кабелями - около 5 тыщ

только не забываем что HikVision обычно идет с бэкдором в комплекте, так что не желательно чтобы в инет торчало ( что впрочем не всегда помогает ).

2. Настраиваем сохранение потока с камеры на писюк или сервер, где будет происходить обработка:

ffmpeg -i "rtsp://192.168.1.10:554/user=admin&password=&channel=3&stream=0.sdp?" -c copy -flags +global_header -f segment -segment_time 1800 -segment_format_options movflags=+faststart -reset_timestamps 1 channel_3_%d.mp4 > log_stream

команда сохраняет получасовые видосики с соответствующего канала/камеры.

Раньше надо было мудохаться с каким нибудь zoneminder теперь же полно нормально работающих программных решений позволяющих работать с потоками видео, что называется из коробки – например выделение участков на видео с движением в отдельные отрывки:

dvr-scan --threshold 2 -tb 1s -tp 1s -l 3s --kernel-size -1 -bb -i filename -m opencv -d detectedevents > log_scan

команда сохраняет моменты, где в видео было движение (+ настройки шумов и продолжительности) в отдельные файлики в папочке detectedevents

3. Анализ – берем самый простой и популярный ultralytics - уже вышла в прод yolo8 , но yolo5 тоже норм работает

#git clone https://github.com/ultralytics/yolov5.git

#cd yolov5

#pip install -r requirements.txt

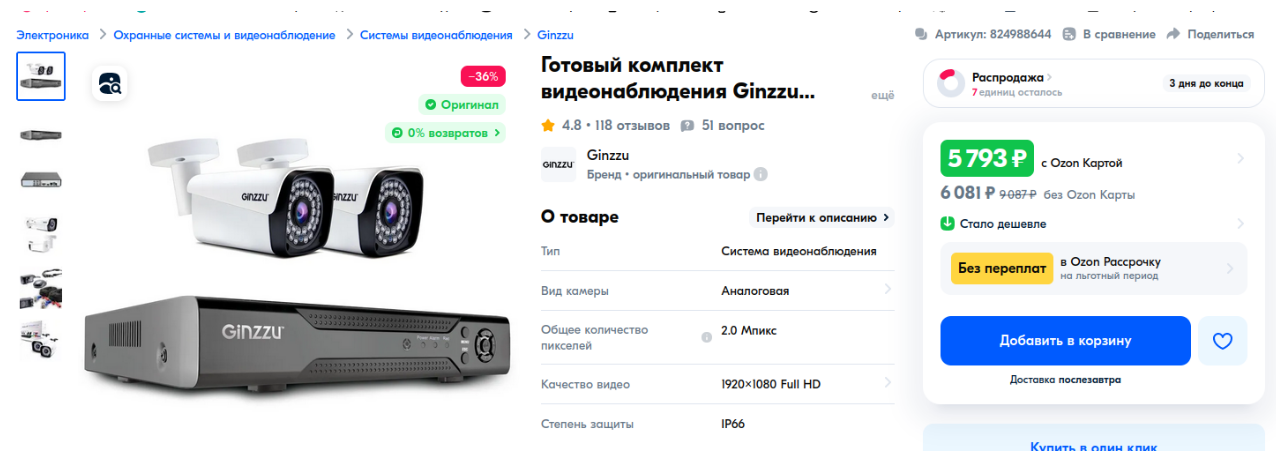

python detect.py --source ./detectedevents/202405261225.mp4 --save-txt –save-csv

раскраска видоса подписями с вероятностью совпадения и выгрузкой в виде уже готовом для загрузки в базу данных.

В таблички вида – дата время, канал , координаты на изображении, классифицированный объект ( вероятность ) .

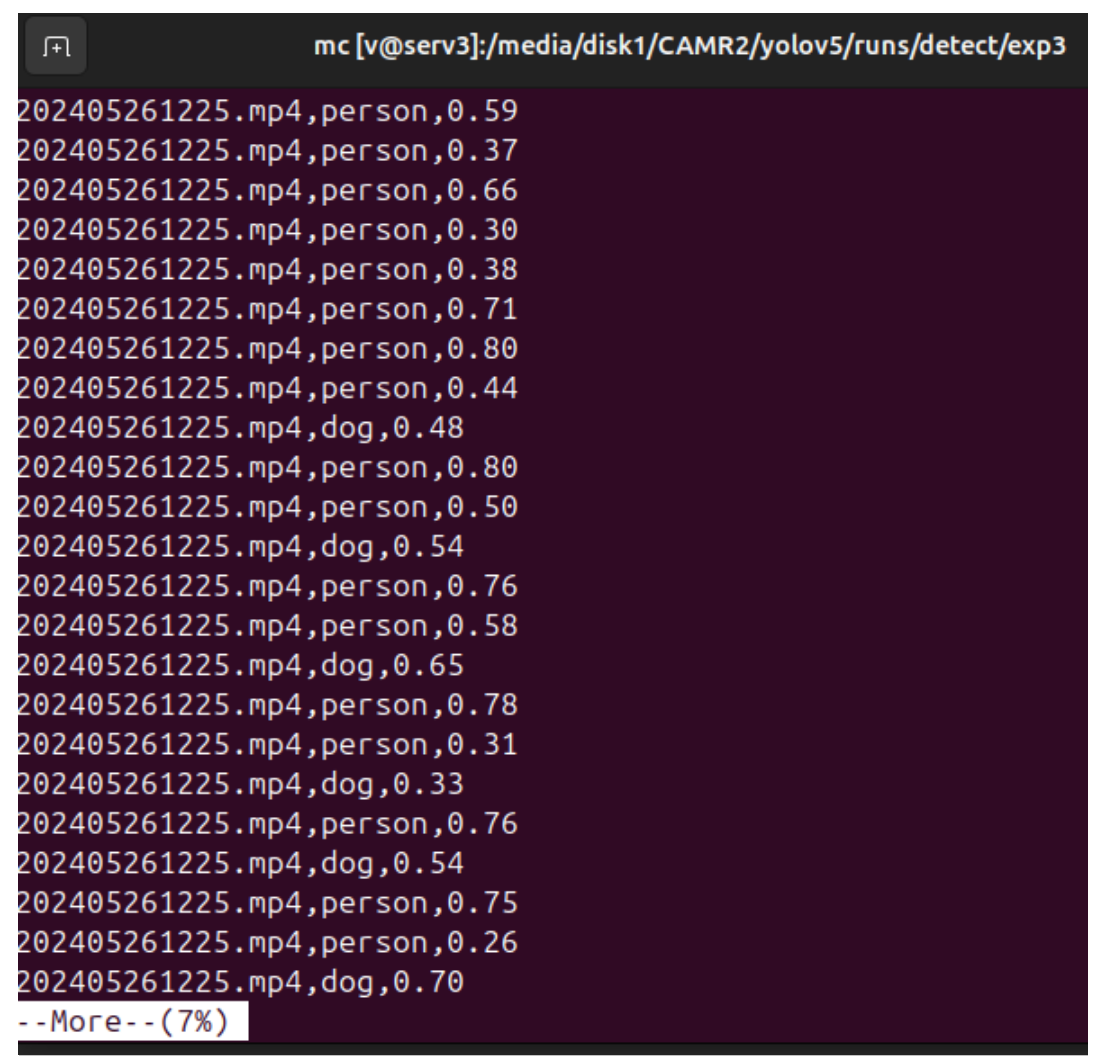

Yolov уже подготовлен для загрузки в FPGA кстати - Келдыш ( https://library.keldysh.ru/prep_vw.asp?pid=9612 )

для yolov2 - https://github.com/markcxli/FPGA_DPU

и прч.

FPGA в 50 энергоэффективней GPU

Итого – пару часов на чтение документации, и если все брать б/у до 10к рублей на круг.

А еще можно это же все запихать на железо современного "персонального переносного следящего устройства", т.е. мобильника-дебильника. Все оптимизировать под и прч.

А можно и сразу условно говоря в "железо", чтобы работало быстро и не ело батарейку, а еще можно попробовать сделать бизнес на продаже интегрированных решений для, как пыталось сделать нвидиа - https://www.nvidia.com/ru-ru/autonomous-machines/embedded-systems/ , не очень пока летает судя по продажам, тем более конкуренты не спят...

Но сегодня не про технические деталях, сегодня о другом.

Очевидно, что можно навесить любую метамодель на обработанные данные – доработать – у автомобилей выделять номера ( и сразу по ним делать запросы к API к другим бгг системам ), человечков сохранять в виде отдельных изображений с подгрузкой к виртуальным профилям... (так работает интернет слежка со стороны типа коммерсов например, когда по поведению выделяют пользователей ты-тупа или вероятно уже и телесрама, если вдруг кто без симкарты зарегился ).

Если речь про "оффлайн" - дополнительный поток для "обогащения" – с bluetooth и wifi детекторов – поток событий, соответственно если человечек прошел несколько раз перед и специфично исказив "электромагнитное" поле на районе то, можно уже составить соответствующую картинку.

После заливки всего добра в БД современные аналитические системы позволяют отвечать на вопросы вроде – кто ходит по утрам на районе и каким маршрутом.

Или покажи всех залетных в этой локации.

С включением по соответствующему тригеру, соответствующих "скриптов" и это далеко не всегда "продажа" какой нибудь ненужной ботвы.

Систем на рынке работающих в таком режиме уже полным полно - не только причем в "информационном" сегменте, но начали появляться решения вокруг правового поля или "индустриального", и Россия одна из лидеров, есть уже и стандарты проектирования мета систем, увязкой с цифровыми двойниками, повышение надежности одновременно с простотой проектирования за счет "модульности" и прч... соответственно дело только в исходных наборах... и что гораздо важнее речь совсем не про "арифмометры", а про мета модели, которые работают уже с агрегированными данными.

Вот тут начинается самое интересное – системы из "модель" – "поток данных" - "тригер" – "реакция" существовали и до появления цифры как таковой.

И реально ржака - сейчас на фоне этого "прогресса" стали легко обнаруживаться условно говоря "Т-800" (в т.ч. самособранные) – когда всех загнали в телесрам с ты-тупом ( до того как, в другие платформы хе хе) – даже собранный на коленке анализатор, но сканирующий всю поляну, моментально выявляет странные аномалии в шаблонах поведения или генерируемых "словесных" потоках отдельных биоединиц, а также механику срабатывания "тригеров" на, по которым уже соответственно восстанавливаются и "архитектуры с принципами устройства", работающих в мета пространстве самих Систем (и анти-систем, бгг).

Следующий уровень это конечно разбор принципов координации и возникновения самих Систем и там уже механики не так много кстати - работают концептуальные моменты.

Для затравки